Hace unos meses nos espantábamos de los accidentes mortales que había tenido el coche autónomo de Tesla. Los medios se hicieron eco que su inteligencia artificial no habia sido tan «lista». La verdad es que viendo como fueron los accidentes poco podria haber hecho ninguna inteligencia. Muy diferente es el caso del Boeing 737 MAX 8. Dos accidentes mortales en menos de 4 meses y la mayor crisis que se recuerda para una de las grandes. No están haciendo demasiado énfasis en que aquí SÍ, aqui la IA, parece ser a todas luces la responsable de los dos accidentes. Y lo que se debería analizar es la diferencia entre un fallo común de software o de como un sistema comete un accidente tomando sus propias decisiones.

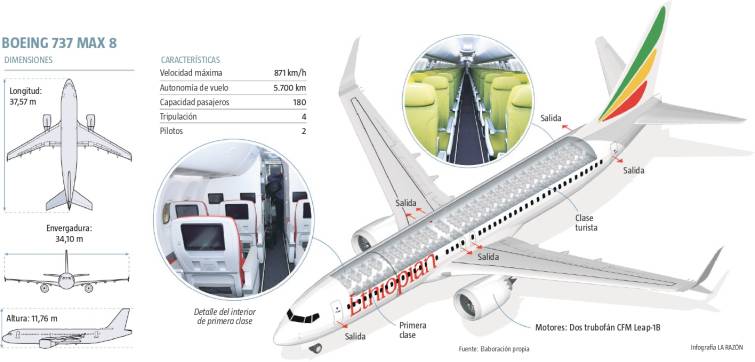

Los sensores de control de vuelos marcaron que su nariz estaba en un ángulo muy elevado, tras lo cual el compensador del estabilizador horizontal respondió bajándola. Se supone que unas malas lecturas de los propios sensores o quizá un mega sistema de control automatico basadado en sistemas Proporciointegrodiferenciales a lo bestia no funcionaron correctamente.

Estos datos enviados al ordenador o una mala programación de estos es un error de software. Pero este avión tan moderno «llevará seguramente» para todos esos casos, un sistema de aprendizaje (machine learning) para todos los casos posibles; y quizá pensando siempre que el ser humano si toca algo lo iba a hacer peor. De esta forma la IA del sistema, con un software mega hermético hizo que el humano no pudo coger el control total de un avión que se resistía a hacerle caso. Sí, ahora sí, estamos ante un caso grave de como una IA mal programada ha matado de decenas de personas. Que facil hubiera sido añadir un botón que apagara todos los sistemas autónomos del avión y que fuera pilotable a la antigua usanza. Pero claro, ahora vendría un piloto suicida y estamos en las mismas. Toca elegir.